Come si misura la coscienza?

Il contributo filosofico allo studio della coscienza – e della discussione ancora più antica sulla natura dell’anima – è un tema che intercetta le grandi domande dell’uomo. Cos’è un uomo. Come funziona. Quanto è diverso dagli altri esseri viventi, dalle piante, dagli altri animali?

Il contributo della neurofisiologia invece, che per qualche aspetto imbocca la scorciatoia del riduzionismo biologico, definisce coscienza la “capacità di esperire” – buttando nel medesimo calderone i fenomeni sensoriali, la programmazione motoria e i processi cognitivi di alto livello – e si concentra invece sul perfezionamento della tecnica, alla ricerca degli strumenti e degli indici che permettono di distinguere le caratteristiche essenziali che permettono di affermare che un uomo “è cosciente” oppure no. La semplificazione è palese ma è ovviamente strumentale: definire secondo standard precisi lo stato di coscienza attuale in un organismo che lo è in potenza è necessario ai fini della diagnosi e dell’orientamento della pratica clinica per tutti quei soggetti in cui si sospetta che tale equilibrio sia compromesso o disturbato.

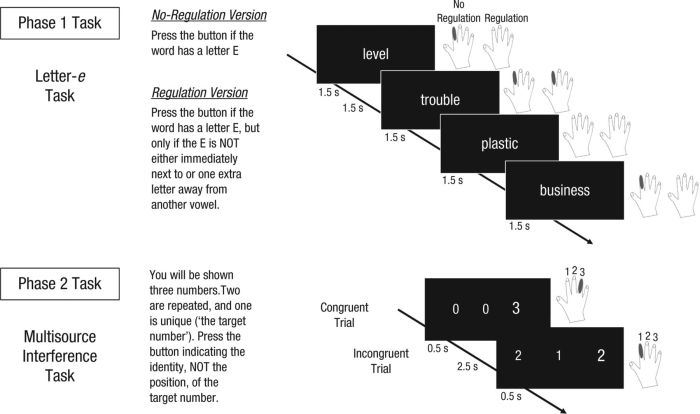

Per farlo, il mezzo più semplice ed immediato è (come avviene per ciascun ambito di ricerca della psicologia sperimentale, ancora prima che in psicofisiologia) l’osservazione della risposta comportamentale. Se un sistema riceve uno stimolo ed è in possesso della capacità di processarlo e delle istruzioni e dei mezzi necessari ad organizzare una risposta coerente, si può inferire che tale sistema sia consapevole della presenza dello stimolo e delle sue qualità: la Coma Recovery Scale traduce perfettamente questo tipo di approccio nell’ambito clinico, andando a sondare il livello della capacità elaborativa e delle risposte autonome e programmate. Oppure ci si può affidare a testimonianze self-report o ancora si può istruire un soggetto umano o un animale di laboratorio a premere un pulsante se l’immagine mostrata a schermo raffigura un volto oppure no.

Il problema delle scale comportamentali è che può capitare che il “sistema” (non si parla quasi mai di “persona”, soprattutto in questi ambiti di ricerca fa poca differenza se i processi cognitivi interessati siano umani o animali) riceva e comprenda bene la natura dello stimolo, ma non sia in grado di rispondere perché danneggiato in qualche punto localizzato più a valle rispetto al sistema centrale dell’elaborazione cosciente. L’esempio clinico è palese nel caso della differenza tra i pazienti in stato di minima coscienza e quelli invece in stato vegetativo, non coscienti. Viceversa, capita che i soggetti affermino di non avere avuto esperienza di uno stimolo, ma sottoposti a test specifici dimostrino risposte positive in percentuale superiore rispetto alla soglia del caso (come avviene nel caso del blindsight).

Per questo, parte della ricerca psicofisiologica ha lavorato per produrre soluzioni alternative alla “semplice” osservazione clinica, nel tentativo di bypassare il proxy della risposta comportamentale (che è il prodotto di una catena lunga e complessa e che può essere compromessa in molti modi).

Nella review di Koch e Tononi pubblicata su Nature lo scorso maggio si parla appunto di questi indici alternativi, di quali sono stati usati fino ad adesso e dell’efficacia predittiva di ciascuno.

Il problema più grande sollevato da K e T è riferito all’equilibrio delicato tra sensibilità e specificità, alla necessità di identificare dei segnali inequivocabili e precisi che correlino con lo stato di coscienza e che mantengano il minimo margine di sovrapposizione possibile con stati attinenti o simili (ad esempio, con tutto ciò che riguarda l’attivazione attentiva di qualsiasi livello, dalla vigilanza ai processi di elaborazione task-related). Per questo è difficile tracciare una neuroanatomia degli stati di coscienza: buona parte delle zone che sembravano candidabili sembrano non reggere alla prova neuropsicologica: non esiste un’area specifica che, danneggiata, porta inevitabilmente alla perdita di coscienza. Lesioni alla corteccia frontoparietale (l’area corticale più attiva durante la veglia) non inducono a stati di coma. La letteratura è piena di casi di soggetti privi di ampie zone corticali o cerebellari che vivono benissimo. Lo stesso tronco encefalico, nel quale troviamo la sostanza reticolare attivante e che in questo senso sembra la struttura neurale più promettente, si è dimostrato comunque insufficiente al mantenimento dell’attività cosciente. La coscienza, in questo senso, si confermerebbe più come la proprietà emergente che nasce dall’attività combinata di una serie di aree e strutture cerebrali che il risultato di un unico “interruttore” centrale.

Un discorso del tutto simile si applica agli indici utilizzati per la registrazione degli stati di coscienza. La registrazione in EEG dell’attività sincronizzata delle aree visive nell’area di frequenza delle onde gamma (30-70 Hz) in gatti svegli o anestetizzati sembrava un buon predittore dell’avvenuto riconoscimento di uno stimolo visivo (e quindi della produzione di un’esperienza visiva), ma in studi successivi si è visto che l’attività gamma correla più con lo stato dei processi attentivi che con l’attività cosciente. Oltretutto si è registrata attività gamma anche in situazioni nelle quali il soggetto cosciente non è (sonno non-REM, durante anestesia) quindi niente. Idem per l’onda P3b registrata coi potenziali evocati, che correla più con la detezione di uno stimolo rilevante (e quindi con l’attività della memoria di lavoro) che con l’esperienza cosciente. E se la ricerca di marcatori EEG specifici non ha avuto grande fortuna, nemmeno il tentativo di estrarre dei pattern globali di attivazione ha funzionato granché bene: è vero che l’attività desincronizzata (bassa ampiezza, alta frequenza almeno nel range delle onde theta) correla piuttosto bene con lo stato di coscienza, se confrontata coi pattern sincronizzati a bassa frequenza, ma purtroppo non abbastanza visto che si sono registrate onde alpha (quelle che “da manuale” descrivono gli stati di veglia rilassata) anche in pazienti in stati di grave coma.

Quindi sembra non esistere una ricetta “facile” (alla faccia del riduzionismo biologico) per inferire lo stato di coscienza. Aree differenti contribuiscono in misura differente (per esempio le aree sensoriali di basso e medio livello per l’esperienza di stimoli modalità-specifici, l’area frontale che è specializzata nell’allocazione delle risorse attentive e nella gestione esecutiva, o anche la hot zone temporo-occipito-parietale che si adatta più specificamente al modello ma che si è visto comunque non essere sufficiente). L’unica soluzione possibile, secondo Koch e Tononi, considera l’intera gamma delle attivazioni corticali: un sistema neurale si trova in uno stato di coscienza quando esprime pattern di attivazione differenziati (cioè produce risposte differenti in base agli stimoli che percepisce) e integrati (cioè si “muove” secondo schemi coerenti). In questo senso la “coscienza” sarebbe il prodotto di un sistema ordinato nel quale l’entropia è limitata e le risorse ben distribuite. Questo stato di organizzazione si può misurare: l’indice PCI, che quantifica lo stato di integrazione complessivo dell’attivazione corticale, registrato in EEG in seguito a stimolazione con TMS, è alto quando il sistema esibisce una buona risposta all’interferenza (e quindi cosciente e difficilmente influenzabile).

Il primo studio, pubblicato su Science Translational Medicine, ad usare introdurre l’uso dell’indice PCI è del 2013, e il nome di alcuni degli autori ricorre in molti dei lavori citati in letteratura. A posteriori, viene da pensare che forse sarebbe stato ancora più interessante se la review fosse stata scritta da un team completamente differente di ricerca, magari con qualche insight a proposito della reliability dell’indice PCI. Ma va bene così, adesso che se ne è parlato su una testata forte come Nature, magari si può sperare in una metanalisi.

Koch, C., Massimini, M., Boly, M., & Tononi, G. (2016). Neural correlates of consciousness: Progress and problems. Nature Reviews Neuroscience Nat Rev Neurosci, 17(5), 307-321. doi:10.1038/nrn.2016.22

http://www.nature.com/nrn/journal/v17/n5/abs/nrn.2016.22.html